摘要:Transformer中的FFN(前馈神经网络)先进行升维再降维的原因在于,升维能够增加网络的表达能力,捕捉更丰富的上下文信息,而降维则有助于减少计算复杂度和参数数量。这种设计背后的原理与机制体现了神经网络在处理序列数据时的效率和灵活性。升维通过增加特征维度来丰富信息表达,而降维则有助于提取关键特征并降低模型过拟合的风险。

本文目录导读:

Transformer模型在自然语言处理领域取得了巨大的成功,其关键组成部分之一是Feed Forward Neural Network(FFN),在FFN中,一种常见的操作是先进行升维(增加特征维度),然后再进行降维(减少特征维度),这样的操作似乎有些复杂和冗余,但其背后有着深刻的原理与原因,本文将详细解析这一过程的原理,以及为什么这种设计在Transformer模型中至关重要。

背景知识

在理解为什么Transformer中的FFN需要首先进行升维再降维之前,我们需要了解FFN的基本结构和Transformer模型的工作原理,FFN通常是一个简单的全连接神经网络,用于对输入数据进行线性变换和非线性激活操作,在Transformer模型中,FFN主要用于对输入序列进行进一步的特征提取和转换。

FFN的升维与降维过程解析

1、升维过程

在FFN中,升维过程主要是通过增加特征维度来实现的,这个过程可以看作是一种对输入数据的扩展,以增加模型的表达能力,通过增加更多的神经元和连接权重,模型可以捕捉到输入数据的更多特征和细节,升维过程有助于模型更好地学习和理解输入数据,为后续的任务(如分类、生成等)提供更有力的支持。

2、降维过程

在升维之后,FFN会进行降维操作,即将特征维度减少,这个过程似乎有些矛盾,因为我们通常认为增加特征维度有助于模型的性能提升,降维过程实际上是为了去除冗余信息、降低模型复杂度、提高计算效率,通过降维,模型可以去除输入数据中的噪声和无关信息,从而更专注于关键特征,降维还有助于减少模型的过拟合风险,提高模型的泛化能力。

四、为什么Transformer中的FFN需要首先进行升维再降维?

1、捕捉复杂特征:Transformer模型在处理自然语言等复杂数据时,需要捕捉输入序列中的丰富特征和模式,升维过程有助于模型更好地学习和理解这些特征,从而提高模型的性能。

2、提高模型表达能力:通过升维,模型可以学习到更复杂的特征和模式,从而增强其表达能力,这对于处理复杂的自然语言处理任务至关重要。

3、去除冗余信息:虽然升维有助于捕捉更多特征,但过多的特征也可能导致模型过于复杂,容易陷入过拟合,降维过程有助于去除冗余信息,降低模型复杂度,提高模型的泛化能力。

4、提高计算效率:降维还可以降低模型的计算复杂度,提高计算效率,这对于处理大规模数据和训练大型模型具有重要意义。

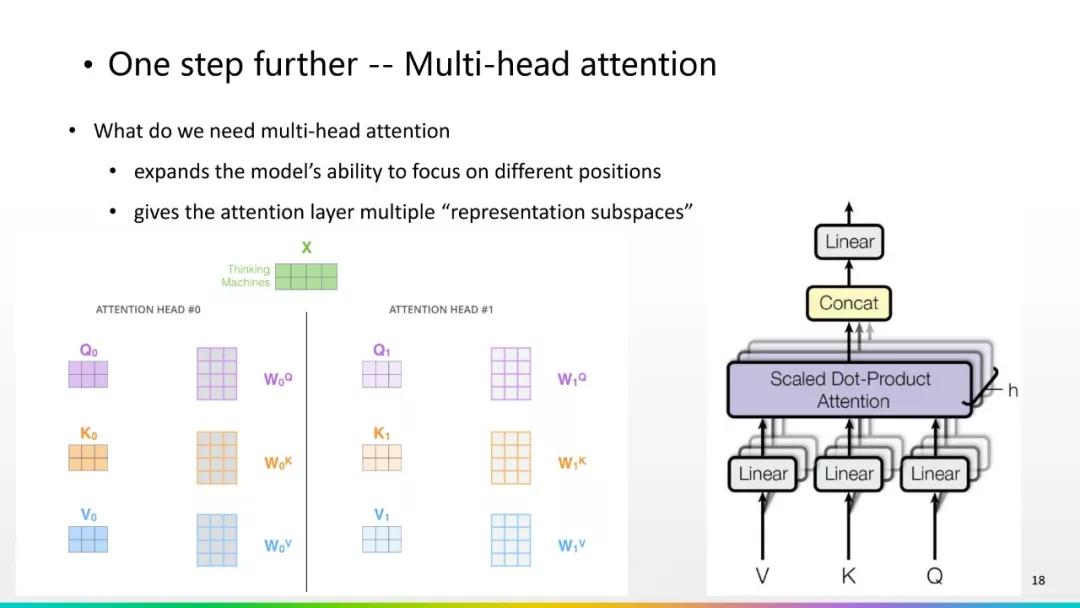

5、结合Transformer的自注意力机制:Transformer模型中的自注意力机制与FFN结合紧密,自注意力机制关注于序列中的关键信息,而FFN则进一步提取和转换这些特征,升维和降维过程有助于这种协同工作,使模型能够更好地捕捉序列中的关键信息和细节。

本文详细解析了Transformer模型中FFN的升维和降维过程,以及为什么需要首先进行升维再降维,通过增加特征维度,模型可以更好地学习和理解输入数据;而通过降低特征维度,模型可以去除冗余信息、降低复杂度、提高计算效率,这种设计有助于模型在捕捉复杂特征和提高计算效率之间取得平衡,从而实现更好的性能。

京ICP备11000001号

京ICP备11000001号